《数据密集型应用系统设计》(DDIA) 深度学习笔记

作者: Martin Kleppmann

学习目标: 系统掌握数据密集型应用设计原理

📋 一、SCQA框架分析

S (Situation - 情境)

现状描述:

- 当今互联网时代,大多数应用都是数据密集型而非计算密集型

- 数据的主要挑战在于:数据量、数据复杂度、数据变化速度

- 技术生态百花齐放: NoSQL、大数据、Web-Scale、分片、最终一致性、ACID、CAP定理、云服务、MapReduce等

核心定位:

“不懂数据库的全栈工程师不是好架构师” —— 译者 Vonng

C (Complication - 冲突)

面临的核心挑战:

-

技术选型困境

- 单一工具无法满足所有需求

- 需要组合多种数据系统(数据库、缓存、消息队列、索引)

- 各种技术的优缺点和适用场景不明确

-

系统设计难题

- 如何确保数据的正确性和完整性?

- 如何在系统退化时提供稳定性能?

- 如何应对负载增长?

- 什么样的API才是好的API?

-

知识碎片化

- 概念繁多,缺乏系统性框架

- 理论与实践脱节

- 历史演进脉络不清晰

Q (Question - 问题)

本书要回答的核心问题:

- 如何设计可靠、可扩展、可维护的数据系统?

- 不同数据模型的本质区别和适用场景是什么?

- 数据存储与检索的底层原理是什么?

- 分布式系统中如何处理数据复制、分区、一致性?

- 如何处理批量数据和实时数据流?

A (Answer - 答案)

本书的核心解决方案:

本书通过三大部分、12章内容,构建了完整的数据系统设计框架:

- 基础: 数据系统的基石(可靠性、数据模型、存储、编码)

- 分布式: 分布式数据处理(复制、分区、事务、一致性)

- 衍生: 批处理与流处理

🗺️ 二、系统思维:全书知识地图

2.1 整体架构(三大部分)

|

|

2.2 系统思维核心连接

因果循环链:

|

|

关键反馈机制:

- 正向反馈: 数据量增长 → 需要分区 → 复杂度上升 → 需要更好的设计

- 负向反馈: 系统监控 → 发现问题 → 容错机制 → 系统稳定

📚 三、分章节深度解析

第一部分:数据系统的基石

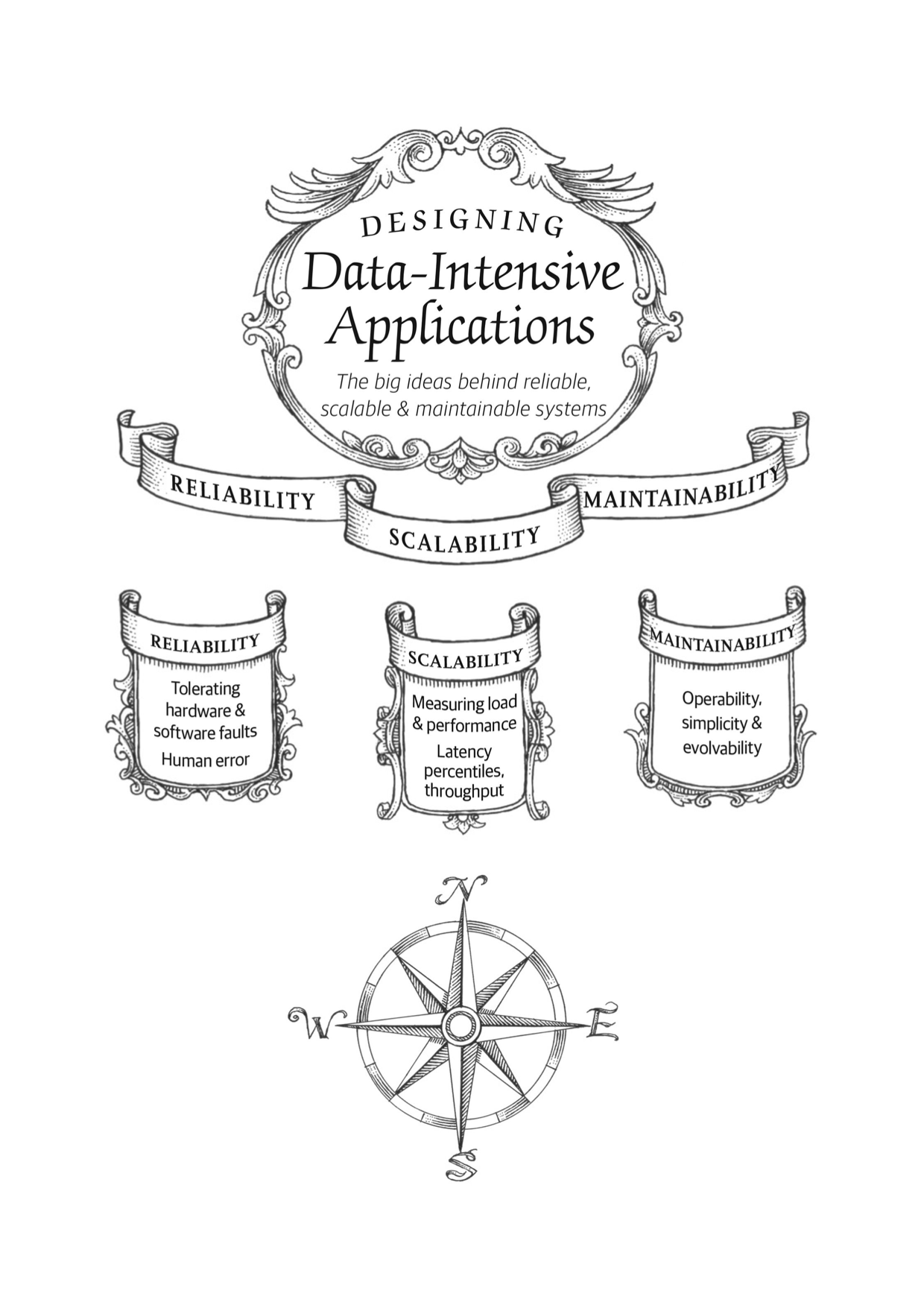

Ch1: 可靠性、可扩展性、可维护性

三大核心设计目标:

-

可靠性 (Reliability)

-

定义: 系统在困境中仍能正常工作

-

故障类型:

- 硬件故障:随机且不相关(磁盘、内存、网络)

- 软件错误:系统性bug,难以预测(级联故障、资源耗尽)

- 人为错误:不可避免的操作失误

-

容错策略:

1 2 3硬件层面: 冗余 + 快速恢复 软件层面: 测试 + 进程隔离 + 降级 人为层面: 良好设计 + 沙箱环境 + 快速回滚

-

-

可扩展性 (Scalability)

-

核心问题: “如果系统以特定方式增长,有什么选项可以应对?”

-

负载参数 (案例:Twitter):

- 方案1: 查询时join(读压力大)

- 方案2: 写入时扇出(写压力大)

- 最终方案: 混合策略(大V用方案1,普通用户用方案2)

-

性能指标:

- 吞吐量 (throughput): 批处理系统关注

- 响应时间 (response time): 在线系统关注

- 使用百分位数 (p50, p99, p999) 而非平均值

-

扩展方式:

- 纵向扩展 (scale up): 升级硬件

- 横向扩展 (scale out): 增加机器

-

-

可维护性 (Maintainability)

- 可操作性: 让运维团队轻松工作

- 简单性: 通过抽象管理复杂度

- 可演化性: 拥抱变化,适应新场景

关键洞察:

这三个目标不是相互独立的,而是相互影响的系统。可靠性是基础,可扩展性确保未来,可维护性决定长期成本。

Ch2: 数据模型与查询语言

数据模型的层次结构:

|

|

三大数据模型对比:

| 维度 | 关系模型 | 文档模型 | 图模型 |

|---|---|---|---|

| 数据结构 | 二维表(行列) | JSON/XML树 | 顶点+边 |

| 关系类型 | 规范化多表 | 嵌套层次 | 任意连接 |

| Schema | 写时约束(强) | 读时解析(弱) | 灵活 |

| 查询语言 | SQL(声明式) | MongoDB查询 | Cypher/SPARQL |

| 优势场景 | 多对多关系 | 一对多关系 | 高度关联数据 |

| 典型应用 | MySQL/PostgreSQL | MongoDB/CouchDB | Neo4j/JanusGraph |

| 局部性 | 差(需join) | 好(树状) | 中等 |

关系模型 vs 文档模型:

|

|

查询语言对比:

-

声明式 (SQL)

- 描述"想要什么"而非"如何获取"

- 数据库自动优化执行计划

- 易于并行化

-

命令式 (传统代码)

- 逐步告诉计算机如何操作

- 优化依赖程序员

- 难以优化

图数据模型:

- 属性图: 顶点+边,都可以有属性

- 三元组存储: (主语, 谓语, 宾语)

- 适用场景: 社交网络、推荐系统、知识图谱

关键洞察:

数据模型不是选择题,而是工具箱。关系模型、文档模型、图模型各有千秋,未来趋势是融合(Multi-Model Database)。

Ch3: 存储与检索

核心问题: 数据库如何高效存储和检索数据?

两大存储引擎家族:

-

日志结构存储引擎 (LSM-Tree)

核心思想: 将随机写转换为顺序写

LSM-Tree架构:

1 2 3 4 5 6 7写入流程: 数据 → MemTable(内存) → SSTable(磁盘L0) ↓ (Compaction) SSTable(L1...Ln) 读取流程: 查询 → MemTable → BloomFilter → SSTable(L0→Ln)优势:

- 写入性能极佳(顺序写)

- 压缩效率高

- 适合写多读少场景

劣势:

- 读放大(需查询多层)

- Compaction占用资源

代表: LevelDB, RocksDB, Cassandra, HBase

-

页面导向存储引擎 (B-Tree)

核心思想: 原地更新固定大小的页面

B-Tree结构:

1 2 3 4 5 6Root Page ├── Internal Page │ ├── Leaf Page (实际数据) │ └── Leaf Page └── Internal Page └── ...特性:

- 页大小通常4KB

- 原地更新

- 使用WAL(预写日志)保证崩溃恢复

优势:

- 读性能稳定

- 每个key只存在一处

- 成熟稳定

代表: MySQL InnoDB, PostgreSQL

LSM-Tree vs B-Tree:

| 维度 | LSM-Tree | B-Tree |

|---|---|---|

| 写入性能 | 优秀 | 中等 |

| 读取性能 | 中等 | 优秀 |

| 空间放大 | 较大(多版本) | 较小 |

| 写放大 | 高(Compaction) | 中(WAL) |

| 适用场景 | 写密集 | 读密集 |

OLTP vs OLAP:

|

|

列存储优势:

|

|

Ch4: 编码与演化

核心问题: 数据格式如何支持系统演化?

编码格式对比:

| 格式 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| JSON | 人类可读,广泛支持 | 体积大,无schema | API,配置 |

| XML | 复杂结构表达 | 冗长,解析慢 | 企业集成 |

| CSV | 简单,通用 | 无类型,列名不明确 | 数据导出 |

| Protocol Buffers | 紧凑,schema演化 | 二进制不可读 | RPC,存储 |

| Thrift | 灵活类型系统 | 生态较小 | Hadoop生态 |

| Avro | schema演化强,压缩好 | 学习成本 | Kafka,HDFS |

数据流的三种类型:

-

通过数据库

- 写入者编码,读取者解码

- 需要考虑schema演化

-

通过服务调用

- REST: 基于HTTP,使用JSON

- RPC: 类似本地函数调用(gRPC, Thrift)

-

通过异步消息传递

- 消息队列: RabbitMQ, Kafka

- 解耦生产者和消费者

Schema演化原则:

|

|

第二部分:分布式数据

Ch5: 复制 (Replication)

复制的三个目的:

- 高可用性:节点故障时系统继续工作

- 低延迟:数据靠近用户

- 高吞吐:分散读取负载

三种复制架构:

-

单主复制 (Single-Leader)

1 2 3 4Leader (接受写) ├── Follower 1 (复制) ├── Follower 2 (复制) └── Follower 3 (复制)复制方式:

- 同步复制:强一致,慢

- 异步复制:快,可能丢数据

- 半同步:折中方案

复制延迟问题:

- 读自己的写: 写入后立即读取不到

- 解决:从主节点读用户自己的数据

- 单调读: 时光倒流现象

- 解决:同一用户总是从同一副本读

- 一致前缀读: 因果关系颠倒

- 解决:相关写入同一分区

-

多主复制 (Multi-Leader)

- 适用场景:多数据中心、离线客户端

- 写入冲突:需要冲突解决策略

- 最后写入胜出 (LWW)

- 版本向量

- 自定义逻辑

-

无主复制 (Leaderless)

- 代表:Dynamo, Cassandra

- 仲裁机制:W + R > N

- W:写入成功的副本数

- R:读取的副本数

- N:总副本数

Ch6: 分区 (Partitioning)

分区目的: 将大数据集分散到多个节点

分区策略:

-

基于键范围分区

1 2 3分区1: [A-D] 分区2: [E-M] 分区3: [N-Z]- 优点:范围查询高效

- 缺点:可能倾斜

-

基于键哈希分区

1hash(key) % N → 分区号- 优点:负载均衡

- 缺点:失去范围查询能力

-

一致性哈希

- 解决节点增减时的数据迁移问题

次级索引的分区:

- 基于文档分区: 每个分区维护自己的次级索引

- 基于词条分区: 全局索引,按词条分区

分区再平衡:

- 固定数量分区

- 动态分区

- 按节点比例分区

Ch7-9: 事务、分布式挑战、一致性与共识

事务的ACID:

|

|

隔离级别:

- 读未提交

- 读已提交

- 可重复读

- 串行化

分布式系统的挑战:

- 网络不可靠

- 时钟不可靠

- 进程可能暂停

一致性模型:

|

|

共识算法:

- Paxos

- Raft

- ZAB (Zookeeper)

第三部分:衍生数据

Ch10-11: 批处理与流处理

批处理 (MapReduce):

|

|

- 适用:离线大数据分析

- 代表:Hadoop, Spark

流处理:

|

|

- 适用:实时分析、监控

- 代表:Kafka Streams, Flink, Storm

Lambda架构:

|

|

Kappa架构:

|

|

🔗 四、跨源比较分析

4.1 与其他经典书籍对比

| 书籍 | DDIA | 《大规模分布式存储系统》 | 《数据库系统内幕》 |

|---|---|---|---|

| 侧重点 | 全栈数据系统 | 存储系统 | 数据库内核 |

| 深度 | 广而深 | 深 | 极深 |

| 实践性 | 强(大量案例) | 中 | 偏理论 |

| 适合人群 | 架构师/后端 | 存储工程师 | 数据库内核开发 |

4.2 与在线课程对比

MIT 6.824 (分布式系统):

- DDIA:理论+实践,更全面

- 6.824:侧重分布式理论和Lab

CMU 15-721 (数据库系统):

- DDIA:更广,覆盖NoSQL和大数据

- 15-721:更深,聚焦数据库内核

4.3 技术演进对比

从单机到分布式的演进:

|

|

DDIA在技术演进中的定位:

不追逐时髦词汇,而是揭示底层原理和权衡(Trade-offs)

⚡ 五、核心概念速查表

5.1 CAP定理

|

|

5.2 BASE理论

|

|

5.3 常见权衡(Trade-offs)

| 维度 | 选项A | 选项B |

|---|---|---|

| 一致性 vs 可用性 | 强一致 | 高可用 |

| 延迟 vs 吞吐量 | 低延迟 | 高吞吐 |

| 读优化 vs 写优化 | B-Tree | LSM-Tree |

| 规范化 vs 反规范化 | 多表join | 数据冗余 |

| 同步 vs 异步 | 数据安全 | 高性能 |

🎯 六、学习路径建议

6.1 基础阶段 (1-4章)

目标: 掌握单机数据系统原理

学习重点:

- 三大设计目标的内涵

- 数据模型的选择标准

- LSM-Tree vs B-Tree

- Schema演化策略

实践项目:

- 实现一个简单的KV存储引擎

- 对比MySQL和MongoDB的使用场景

6.2 进阶阶段 (5-9章)

目标: 理解分布式系统核心问题

学习重点:

- 复制延迟及解决方案

- 分区策略选择

- 事务隔离级别

- 一致性模型

实践项目:

- 使用Raft实现分布式KV

- 分析Redis Cluster的分区方案

6.3 高级阶段 (10-12章)

目标: 掌握数据流处理

学习重点:

- MapReduce工作原理

- 流处理vs批处理

- Lambda/Kappa架构

实践项目:

- 使用Kafka Streams构建实时管道

- 实现一个小型流处理框架

💡 七、关键洞察与启发

7.1 设计哲学

1. 没有银弹

每种技术都有其适用场景和限制,关键是理解权衡(Trade-offs)

2. 简单性至关重要

复杂度是系统的最大敌人,应通过抽象管理复杂度

3. 数据系统是演化的

系统必须支持演化,包括Schema演化、版本兼容

7.2 实践智慧

架构设计清单:

|

|

常见反模式:

- ❌ 过早优化

- ❌ 盲目追随流行技术

- ❌ 忽视运维和监控

- ❌ 没有考虑演化路径

7.3 未来趋势

根据本书和技术发展,数据系统的未来方向:

-

Serverless数据库

- 按需扩展

- 分离计算和存储

- 代表:Aurora Serverless, Neon

-

多模型数据库

- 融合关系、文档、图

- 代表:ArangoDB, OrientDB

-

AI驱动优化

- 自动索引推荐

- 自动参数调优

-

隐私增强技术

- 同态加密

- 联邦学习

📖 八、延伸阅读建议

8.1 论文推荐

每章末尾都有高质量引用,特别推荐:

基础论文:

- Bigtable: A Distributed Storage System

- Dynamo: Amazon’s Highly Available Key-value Store

- MapReduce: Simplified Data Processing

共识算法:

- Paxos Made Simple

- In Search of an Understandable Consensus Algorithm (Raft)

8.2 开源项目学习

理解LSM-Tree: LevelDB源码 理解B-Tree: SQLite源码 理解分布式: etcd(使用Raft), TiDB 理解流处理: Kafka源码

8.3 实践环境

-

本地环境:

- Docker搭建各种数据库

- 使用Vagrant模拟分布式环境

-

云环境:

- AWS: DynamoDB, Aurora

- GCP: Bigtable, Spanner

🔥 九、速记卡片

数据系统设计的核心铁律

|

|

技术选型决策树

|

|